L’essor inquiétant des deepfakes porno

Une tendance inquiétante se profile à l’horizon numérique : l’utilisation croissante de l’intelligence artificielle pour créer des images nues de personnes sans leur consentement.

Lors d’un de mes ateliers organisés dans le Nord de la France [Communauté de Communes Pévèle], en novembre 2023, une jeune fille m’interpelle à la fin de la conférence. Elle a attendu que ses camarades quittent la salle. Elle va m’expliquer avoir reçu des photographies d’elle dans des situations pornographiques qui ont choqué cette lycéenne. Le malveillant avait utilisé un logiciel permettant de fusionner n’importe quelle tête sur des photographies tirées de sites pour adultes. Cette pratique, baptisée DeepFake Nude, fait appel à des applications et des sites Web. Le Service veille ZATAZ a pu en repérer plusieurs, sur le web et dark web.

La montée en puissance des deepfakes x

Les deepfakes, ces médias manipulés par l’intelligence artificielle pour sembler réels, sont de plus en plus utilisés pour créer des images nues de personnes à partir de photos où elles sont habillées. Les données montrent que ces services sont de plus en plus populaires, avec 34 sites Web recensant plus de 24 millions de visiteurs uniques en septembre dernier, selon l’entreprise d’analyse sociale Graphika. Cette tendance est également alimentée par une augmentation spectaculaire des liens de spam renvoyant vers ces sites et applications, qui ont augmenté de plus de 2 000 % depuis le début de l’année sur des plateformes telles que X et Reddit.

Des documents pouvant rapidement devenir des outils pour des sextortion

De manière préoccupante, plus de 53 groupes Telegram proposent des services de Clothes Remover (retirer les vêtements), comptant au moins 1 million d’utilisateurs, ont été repérés par le service veille ZATAZ. Plus de 100 sites web et dark web ont été référencés. Cette popularité croissante des deepfakes « déshabillés » ouvre la porte à une série de problèmes en ligne, notamment la création et la diffusion non sollicitée d’images nues, le harcèlement ciblé, la sextorsion et même la production de matériel pédopornographique.

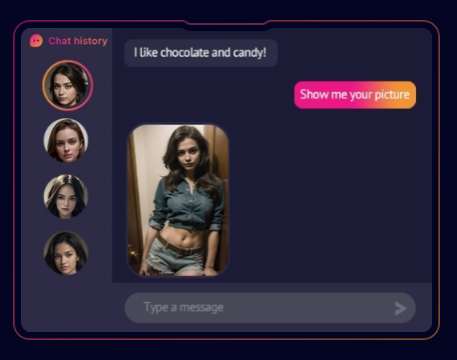

Plusieurs sites spécialisés dans le commerce de la pornographie ont lancé leur propre intelligence artificielle via des abonnements ou des options gratuites.

Les conséquences dévastatrices

Un exemple de ces problèmes est survenu en février 2023, lorsque la streameuse Twitch QTCinderella a été victime de fausses vidéos pornographiques la représentant. Après avoir découvert ces vidéos, elle a partagé son ressenti en déclarant : « La quantité de dysmorphie que j’ai ressentie en voyant ces photos m’a détruite. C’est bien plus que simplement violer les limites personnelles.«

En septembre 2023, de fausses images nues de plus de 20 jeunes filles ont circulé dans plusieurs écoles espagnoles, générées par une application basée sur l’IA, comme le rapporte El País. Ces incidents ne sont que la pointe de l’iceberg, car le phénomène des deepfakes nudistes continue de s’étendre.

La jeune fille que j’ai rencontré lors de mes ateliers de novembre 2023 a été présentée à la Gendarmerie Nationale afin qu’elle puisse déposer plainte et faire condamner le/la malveillante derrière les documents produits. L’interlocuteur lui avait expliqué avoir créé les images, certaines très explicites, « comme des œuvres d’art » (sic!).

Le FBI alerte

Le Bureau fédéral d’enquête des États-Unis, le FBI, mettait en garde l’été dernier (2023) contre une augmentation des campagnes d’extorsion où des criminels exploitent des outils d’intelligence artificielle (IA) facilement disponibles pour créer des deepfakes à caractère sexuel à partir de photos innocentes de personnes, puis les harcèlent ou les font chanter.

Selon son communiqué du 5 juin 2023, le Bureau fédéral avait reçu un nombre croissant de signalements de victimes « dont les photos ou vidéos ont été altérées pour contenir du contenu explicite. » Ces vidéos, mettant en scène des adultes et des mineurs, circulent sur les réseaux sociaux ou les sites pornographiques.

Généralement, dans les cas de sextorsion, la victime est approchée en ligne par une personne se faisant passer pour quelqu’un d’autre. Elle maintient le contact avec la victime jusqu’à ce qu’elle reçoive les images/vidéos explicites. Dans le cas de l’extorsion alimentée par les deepfakes, les fausses images sont le moyen par lequel les victimes sont prises en otage – pas besoin d’établir une relation amicale au préalable.

Certains sites proposent de faux tchats exploitant des photos « retravaillées » avec l’IA. Tout est faux, même la discussion.

Le problème croissant des deepfakes

Les deepfakes sont créés à l’aide de réseaux neuronaux, ce qui permet aux utilisateurs de falsifier efficacement l’apparence ou l’audio d’une personne. Dans le cas du contenu visuel, ils sont formés pour prendre une vidéo en entrée, la compresser via un encodeur, puis la reconstruire avec un décodeur. Cela pourrait être utilisé pour transposer efficacement le visage d’une cible sur le corps de quelqu’un d’autre et le faire imiter les mêmes mouvements faciaux que la personne d’origine.

La technologie existe depuis un certain temps. Un exemple viral était une vidéo de Tom Cruise jouant au golf, faisant de la magie et mangeant des sucettes, qui a recueilli des millions de vues avant d’être supprimée. La technologie a bien sûr été utilisée pour insérer les visages de célébrités et d’autres personnes dans des vidéos suggestives.

Le Youtubeur MrBeast avait du faire face à une vidéo deep fake. Les images et sa voix vantaient un site dédié aux crypto-monnaies. Un faux site, une fausse vidéo, mais une vraie arnaque.

Comment contrer les créateurs de deepfakes

Réfléchissez toujours à deux fois avant de publier des images, des vidéos et d’autres contenus personnels. Le contenu le plus anodin pourrait théoriquement être utilisé par des acteurs malveillants sans votre consentement pour en faire un deep fake.

Renseignez vous sur les paramètres de confidentialité de vos comptes de médias sociaux. Il est logique de rendre les profils et les listes d’amis privés, de sorte que les images et les vidéos ne soient partagées qu’avec ceux que vous connaissez. Soyez toujours prudent lorsque vous acceptez des demandes d’amis de personnes que vous ne connaissez pas.

Ne partagez jamais de contenu avec des personnes que vous ne connaissez pas. Soyez particulièrement méfiant envers les individus qui vous poussent à partager un contenu spécifique. Méfiez-vous des « amis » qui commencent à agir de manière inhabituelle en ligne. Leur compte a peut-être été piraté et utilisé pour obtenir du contenu et d’autres informations. Utilisez toujours des mots de passe complexes, uniques et l’authentification à deux facteurs (2FA) pour sécuriser vos comptes de médias sociaux.

Effectuez des recherches régulières en ligne pour identifier toutes les informations personnelles ou le contenu vidéo/image qui sont disponibles publiquement.

ZATAZ vous propose des outils dans son espace dédié à l’OSINT. Envisagez des recherches inversées d’images pour trouver des photos ou des vidéos qui ont été publiées en ligne sans votre connaissance. Ne jamais envoyer d’argent ou de contenu graphique à des individus inconnus. Ils en demanderont toujours davantage.

Signalez toute activité de sextorsion à la police, à la gendarmerie et à la plateforme concernée (site web, médias sociaux, Etc.) Réfléchissez à deux fois avant de publier du contenu de vos enfants, ami(e)s dans lequel leurs visages sont visibles.