L’IA fantôme : une menace silencieuse qui pourrait provoquer une crise de sécurité mondiale

L’essor incontrôlé des outils d’IA dans les entreprises menace la sécurité des données à une échelle sans précédent. En 2025, la « sécurité de l’IA » deviendra une priorité absolue pour les responsables de la cybersécurité, dépassant la cybersécurité classique et la protection des données. Retour sur l’affaire Disney, le Shadow AI et les 44 millions de messages internes.

Les outils d’intelligence artificielle (IA) s’infiltrent discrètement dans le quotidien des entreprises, offrant des gains de productivité tout en ouvrant la porte à des failles de sécurité majeures. Ce phénomène, surnommé « Shadow AI » (IA fantôme), pourrait devenir le principal défi des responsables de la sécurité des systèmes d’information (RSSI) dès 2025. La fuite de données massive subie par Disney en 2023 illustre les conséquences potentielles de cette menace invisible, souvent ignorée par les politiques de sécurité traditionnelles.

La catastrophe Disney : un signal d’alarme pour le monde de l’entreprise

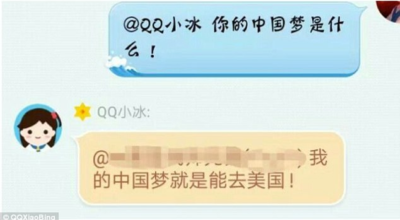

En juillet 2023, Matthew Van Andel, un ancien employé de Disney, a reçu un message anonyme glaçant sur Discord : « Je détiens des informations sensibles sur votre vie privée et votre travail. » L’auteur du message a non seulement reproduit avec précision une conversation privée tenue sur Slack, mais il a également révélé des informations sensibles : son numéro de carte de crédit, son numéro de sécurité sociale et même ses identifiants de connexion à sa caméra connectée Ring.

Van Andel a rapidement compris qu’il avait été piraté. Mais le pire était à venir. Dès le lendemain, le groupe de bad hackers Nullbulge a publié en ligne plus de 44 millions de messages internes de Disney. Parmi les informations divulguées figuraient des données sur la confidentialité des clients, des numéros de passeport des employés et des informations sensibles sur les revenus des parcs à thème et du service de streaming Disney+.

Le point d’entrée de cette attaque ? Un logiciel d’IA téléchargé par Van Andel depuis GitHub en février 2023. Ce générateur d’images basé sur l’IA, apparemment inoffensif, contenait en réalité un cheval de Troie sophistiqué. Ce malware a permis aux pirates de voler les identifiants stockés dans son gestionnaire de mots de passe 1Password, qui n’était pas protégé par une authentification à deux facteurs. Avec cet accès, les pirates informatiques ont pu infiltrer le réseau interne de Disney en utilisant des cookies de session Slack volés. Les pirates sont restés dormants pendant cinq mois avant de déclencher une attaque coordonnée.

« L’IA fantôme est déjà une arme redoutable pour les pirates, transformant chaque employé en porte d’entrée potentielle. »

Shadow AI : le cheval de Troie moderne

L’affaire Disney n’est pas un cas isolé. Selon une enquête menée par Google Mandiant, près de 40 % des cyberattaques à but lucratif en 2023 ont été facilitées par des identifiants volés, soit le double par rapport à 2022. Cette explosion est directement liée à la prolifération des outils d’IA utilisés sans supervision dans les entreprises.

Le phénomène de « Shadow AI » repose sur une tendance lourde : les employés utilisent des outils d’IA non autorisés pour améliorer leur efficacité personnelle ou combler les lacunes des solutions internes. D’après le rapport Work Trend Index 2024, 78 % des employés déclarent utiliser des outils d’IA personnels au travail, mais 52 % hésitent à l’admettre, de peur de représailles ou de sanctions. Une autre étude montre que 74 % des utilisateurs de ChatGPT, Gemini et Bard se connectent via des comptes personnels, échappant ainsi totalement aux politiques de sécurité de leur entreprise.

Les motivations sont claires : face à des outils internes souvent lourds ou inefficaces, les employés recherchent des solutions rapides pour automatiser des tâches répétitives, rédiger du contenu ou analyser des données. Mais cette commodité a un prix.

Une étude d’IBM révèle que 38 % des employés admettent avoir partagé des informations professionnelles sensibles avec des outils d’IA non autorisés. Ces données sont souvent stockées sur des serveurs externes, échappant au contrôle de l’entreprise. L’utilisation de modèles d’IA open source aggrave le risque, car ces plateformes sont particulièrement vulnérables aux attaques.

« L’IA fantôme est un cancer pour la sécurité des entreprises : elle ronge la protection des données de l’intérieur. »

Le secteur financier et le domaine de la santé sont particulièrement vulnérables. Le rapport CX Trends 2025 révèle que l’utilisation de l’IA fantôme dans ces secteurs a augmenté de 250 % d’une année sur l’autre, créant une urgence réglementaire.

Une étude de Dell montre que 91 % des employés ont essayé l’IA générative et 71 % l’utilisent déjà au travail. Les entreprises ne peuvent plus ignorer cette tendance.

Vous voulez suivre les dernières actualités sur la cybersécurité ?

Pour rester informé sur les enjeux de cybersécurité, abonnez-vous à la newsletter de ZATAZ. Rejoignez également notre groupe WhatsApp et nos réseaux sociaux pour accéder à des informations exclusives, des alertes en temps réel et des conseils pratiques pour protéger vos données.